Gemma - otwarty LLM od Google miażdży konkurencję

Google wypuścił dwa małe otwarte modele na liberalnej licencji komercyjnej. Mają konkurować z Llamą 2 i Mistral.

Google ogłosił dziś premierę modelu Gemma, a dokładniej dwóch nowych modeli AI: Gemma 2B i Gemma 7B. Nowe LLM mają wyprzedzać konkurencyjne Llama 2 i Mistral. Są udostępniane z liberalną licencją komercyjną.

Nowa rodzina modeli AI

Gemma 2B i Gemma 7B to mniejsze modele sztucznej inteligencji, które Google udostępnił jako otwarte źródło, co pozwala developerom na swobodne korzystanie z technologii wykorzystanych do budowy flagowego modelu Gemini. Tris Warkentin, dyrektor Google DeepMind, opisuje nowe modele jako "nową rodzinę najnowocześniejszych mniejszych modeli, które umożliwią developerom badania i rozwój sztucznej inteligencji w otwartym środowisku przy użyciu narzędzi opartych na badaniach i technologiach, których używamy również do budowy Gemini".

Otwartość modelu Gemma

W przeciwieństwie do zamkniętego modelu Gemini, Gemma została udostępniona w otwartym ekosystemie, co pozwala większej liczbie osób eksperymentować ze sztuczną inteligencją Google'a. Trzeba tu jednak zaznaczyć, że termin "otwarty" nie oznacza tutaj open-source - Google określa modele Gemma jako "otwarte", ponieważ są one dostępne dla szerokiego grona developerów i badaczy, ale mają swoje specyficzne warunki użytkowania.

Udostępnione zostały:

- Wagi modeli 2B i 7B

- Narzędzia do fine-tuningu modeli dla JAX, PyTorch czy TensorFlow (za pośrednictwem Keras)

- Notatniki w Colabie i Kaggle

- Modele gotowe do uruchomienia

- Responsible Generative AI Toolkit, który zawiera poradniki i narzędzia służące do tworzenia bezpieczniejszych aplikacji opartych na modelach Gemma

Jak z tą przewagą nad konkurencją?

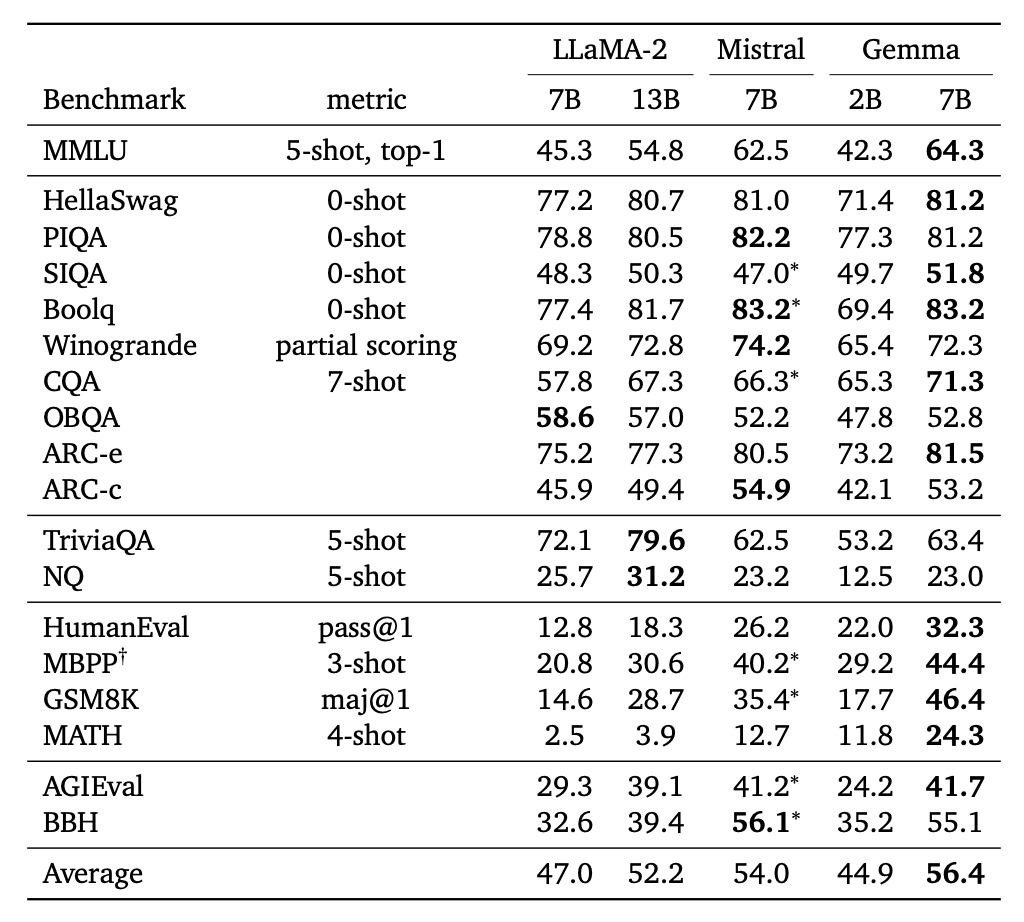

Google wypuszczając modele Gemma konkuruje z Llama-2 od Facebooka, a też z modelem Mistral. Twierdzą, że od obydwu są lepsi, podpierając to wynikami benchmarków. Gemma 2B jest bardzo imponującym modelem biorąc pod uwagę liczbę parametrów. Natomiast Gemma 7B zdecydowanie lepiej radzi sobie z matematyką i kodem niż Llama-2 13B czy Mistral.

Porównanie benchmarków modeli Gemma, Llama-2 i Mistral, źródło - raport techniczny Gemma

Co poza tym pozwala wnioskować Google'owi, że Gemma jest lepsza od konkurencyjnych modeli?

- Rozmiar i złożoność - Gemma jest mniejszym modelem w porównaniu z konkurencyjnymi rozwiązaniami, co sprawia, że jest lżejsza i szybsza w użyciu. Jest to szczególnie korzystne do zastosowań, gdzie duże modele są niepotrzebnie złożone lub zbyt kosztowne w zasoby obliczeniowe, szczególnie ciekawe będzie tu zastosowanie modelu 2B.

- Wydajność i koszty - Mimo mniejszego rozmiaru, Gemma osiąga wydajność porównywalną do większych modeli. Google twierdzi, że sporo czasu spędzili nad optymalizacją modeli (w partnerstwie z Nvidią).

- Bezpieczeństwo- dużo miejsca w ogłoszeniu nowych modeli Google poświęcił bezpieczeństwu, wspomiany już Responsible Generative AI Toolkit ma zapewniać bezpieczeniejszą klasyfikację czy narzędzia do debugowania zachowania modelu.

Zastosowania Gemma

Zastosowania nowego modelu od Google obejmują działania związane z generowaniem tekstu. Poza tym może być wykorzystany do zadawania pytań, analizy tekstów, czy tłumaczenia, pomagając w zrozumieniu i przetwarzaniu języka naturalnego. Tworzenie tekstu i rozumienie przez mniejsze modele znacząco wzrosło w ciągu ostatniego roku, dzięki czemu możliwe jest budowanie aplikacji opartych na AI bez konieczności korzystania z większych modeli językowych.

Licencja komercyjna

Google zapewnia, że modele Gemma mogą być używane zarówno w celach badawczych, jak i komercyjnych. Udostępnia "komercyjnie przyjazną licencję" dla tych modeli. Firmy mogą korzystać z modeli Gemma bez ograniczeń co do rozmiaru organizacji czy liczby użytkowników, jednak Google zobowiązuje się do monitorowania wykorzystania tych narzędzi, aby zapewnić odpowiedzialne podejście do ich używania. Zachęca też do przetestowania modelu, na Kaggle, w Google Colab, albo w chmurze.