AI gorsze od człowieka w tworzeniu treści

Okazało się, że człowiek nadal tworzy lepsze treści niż AI, ze względu na problemy sztucznej inteligencji z logicznym rozumowaniem.

Badanie wykazało, że generatory tekstów oparte na sztucznej inteligencji są w stanie tworzyć treści poprawne gramatycznie, ale jeżeli chodzi o zgodność z prawami otaczającego nas świata, to ludzie są nadal lepsi. Zespół naukowców z University of Southern California, University of Washington oraz Allen Institute for Artificial Intelligence opracował testy badające umiejętności logicznego rozumowania. Polegały one na układaniu zdań, wykorzystując do tego podane rzeczowniki i czasowniki.

W tym artykule pokażemy, jak wyglądały niektóre wyniki i co oznaczają one w kontekście rozwoju AI.

Człowiek lepszy od AI

Jeden z generatorów tekstów (a dokładnie UniLM lub Unified Language Model) otrzymał od naukowców następujące wyrazy: pies, frisbee, rzucać, łapać. Tak brzmiało zdanie, które stworzył:

Dwa psy rzucają do siebie frisbee.

Pomimo że powyższe zdanie jest zrozumiałe i poprawne gramatycznie, to jednak nie jest to coś, co napisałby człowiek. Obraz psów rzucających sobie frisbee nie jest w sumie aż tak dziwaczny, ale o wiele bardziej prawdopodobne jest to, że to człowiek będzie coś takiego robił.

Yuchen Lin, doktorant z University of Southern California, stwierdził, że teksty wygenerowane przez sztuczną inteligencję są w zdecydowanej większości poprawne gramatycznie, ale przedstawione w nich scenariusze są albo niemożliwe, albo po prostu zbyt dziwaczne, jak na świat, w którym żyjemy.

Mamy tutaj też takie zdanie, jak „kosz na śmieci stoi pod albo na stole”. Raczej mało prawdopodobne jest to, aby ktoś postawił kubeł ze śmieciami na stole, gdzie spożywa posiłki i napoje. Stawianie kosza pod stołem też brzmi dosyć słabo, ale jest już trochę bardziej zgodne z prawami otaczającego nas świata.

Szczegóły badania

Naukowcy stworzyli zestaw danych zawierający 35 141 scenariuszy przedstawionych przez 77 449 zdań uformowanych przez ludzi. Jak na razie przetestowano 8 generatorów tekstów opartych na sztucznej inteligencji.

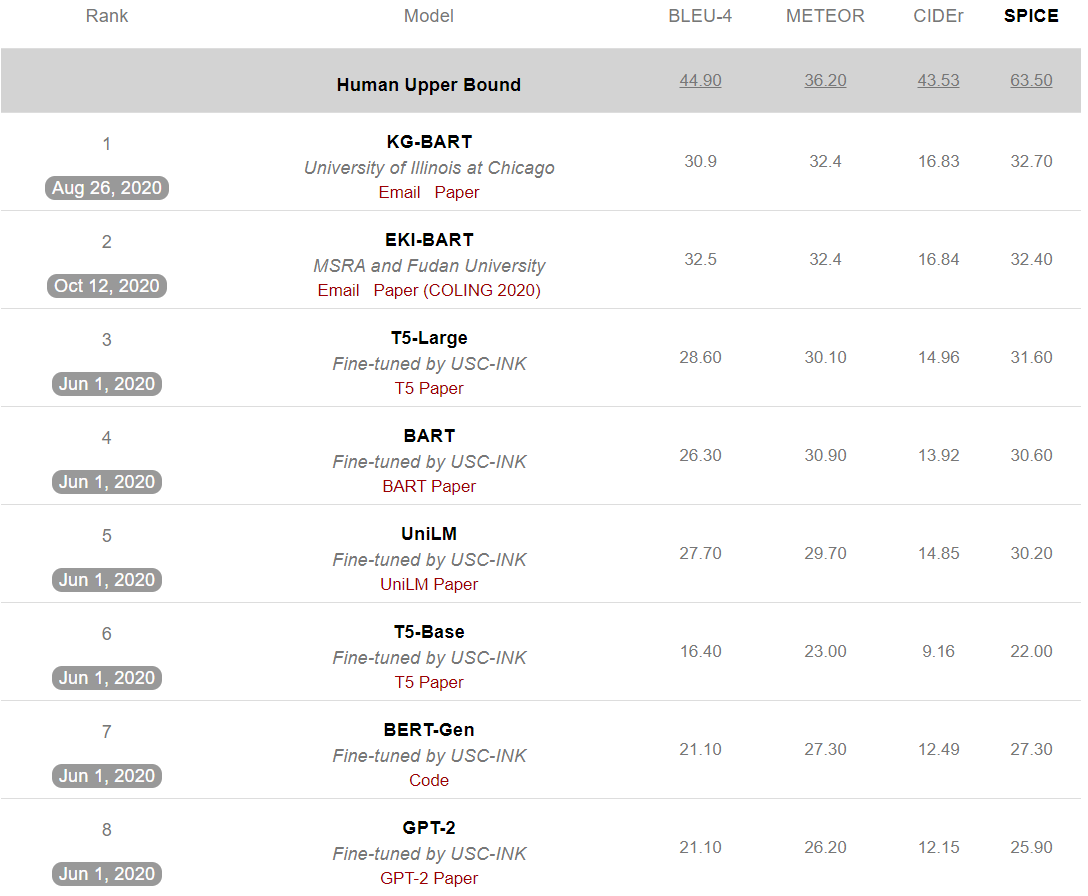

Na potrzeby ewaluacji wyników użyto kilku popularnych metryk wykorzystywanych do pomiaru różnic między tekstem maszynowym a ludzkim — mówi Yuchen Lin. Te metryki to BLEU, METEOR, CiDER, oraz SPICE.

Lin tłumaczy dalej, że metryki BLEU i METEOR są bardziej dopasowane do takich zadań, jak tłumaczenie maszynowe, a więc skupiają się one bardziej na dokładności konkretnych słów. CiDER i SPICE są nakierowane na pomiar treści pod kątem tworzonych scenariuszy, dlatego są one bardziej odpowiednie dla tego badania.

Według tablicy wyników z University of Southern California najlepiej wypada KG-BART, który został stworzony przez badaczy z University of Chicago i uzyskał tutaj 32,7% w metryce SPICE. Model T5-Base od Google z kolei uzyskał tam tylko 22%.

Oto jak prezentuje się pełna tablica wyników:

Ogólnie widać, że systemy oparte na uczeniu maszynowym uzyskały o wiele niższe wyniki niż ludzie, którzy mają 63,5% dokładności w metryce SPICE.

Podsumowanie

Lin oraz inne badacze twierdzą, że jeśli AI nie potrafi rozumować tak jak człowiek, to pojawią się problemy w interakcjach z takimi aplikacjami, jak asystenci głosowi, czy boty. Sieci neuronowe nie są często w stanie rozwinąć umiejętności logicznego myślenia, bo ich nauka opiera się na zapamiętywaniu rzeczy z zestawów danych — i nie rozumieją przez to otaczającego nas świata.

Badacze mają nadzieję, że przez rozwinięcie testów na logiczne rozumowanie, naukowcy będą w stanie pisać w przyszłości lepsze algorytmy.

Czy AI niedługo prześcignie człowieka w jakości tworzonych treści? Napisz, co myślisz w komentarzu ?